H asta ahora hemos echado una ojeada a la visión clásica de la ciencia moderna, al paradigma que nació con este nuevo modo de conocer tan exitoso, pues ha proporcionado al hombre una significación de su mundo que le ha beneficiado a través de aplicaciones prácticas palpables. Pero de acuerdo al marco teórico que hemos presentado en anteriores artículos, la ciencia evoluciona por medio de largos periodos de ciencia normal seguidos de rupturas o revoluciones en sus paradigmas, y a lo largo de los prácticamente seis siglos de su existencia el conocimiento científico ha llegado a descubrimientos que no pueden ser explicados con el paradigma tradicional, dando lugar a nuevas teorías que de una u otra manera han logrado acomodarse dentro del mismo, pero causando una tensión que ha obligado a científicos y filósofos de la ciencia a plantear la necesidad de un nuevo paradigma que sustituya al tradicional.

Este planteamiento paradigmático ha aparecido en el pensamiento de varios autores con diferentes nombres: teoría de la complejidad, ciencia de la totalidad, teoría del caos... Todos ellos, aún con algunas diferencias, reúnen una serie de planteamientos comunes que trataremos de resumir en las próximas líneas, como fundamento interesante para un modelo de educación que busca romper las fronteras de la disciplinariedad. La ciencia clásica, la que nació entre los siglos XV y XVII y que dominó bajo el influjo de una visión positivista que buscaba marcos universales unificadores donde todo cabía y podía ser explicado en función de leyes eternas e inmutables, también fue rechazada por ciertos sectores que consideraban que su visión mecánica del mundo, su concepción de la realidad como un autómata sujeto a leyes inamovibles, dejaba al hombre aislado de un mundo con el que no se identificaba. Y es que la ciencia moderna, con su particular método de interrogar a la realidad, ha establecido una nueva relación del hombre con la naturaleza, pero se trata de un diálogo entre un ente pasivo que se comporta mecánicamente siguiendo eternamente reglas inscritas en su programa y un ser pensante dotado de voluntad, libertad, sentimientos y autonomía, un ser que, a fin de cuentas, se siente solo y aislado frente a la inmutable indiferencia del universo.

Así, el inicial entusiasmo con que fue acogido este nuevo modo de conocer se pagó y se convirtió en hostilidad hacia un nuevo mundo gobernado por la racionalidad y el determinismo. Y la sociedad humana terminó estableciendo una marcada división entre dos culturas: las humanidades y la ciencia. Para la primera, la ciencia se ha convertido en un mal moderno que amenaza seriamente la vida cultural de los hombres. Esta amenaza se encarna, no en la tecnología o en los resultados del saber de la ciencia, sino en el espíritu científico mismo y su racionalidad extrema, que reduce la riqueza y diversidad del mundo 1 a una maquinaria simplificada cuyo funcionamiento ha sido descifrado.

Esto ha llevado al hombre a una de dos conclusiones:

a) A la idea de que la humanidad es parte del proceso mecánico que rige al mundo, lo que le despoja de su carácter semidivino: “Ahora la humanidad se consideraba el producto de una improbable colisión de partículas que obedecían a indiferentes leyes universales. Destronados en cuanto vástagos de los dioses, los humanos se entronizaron en cuanto poseedores de conocimientos acerca de esas leyes” (Briggs y Peat, op.cit. :22). Esta fue la conclusión a la que llegaron los defensores de la ciencia positiva.

b) A que, como ser único dotado de libertad, de razón y capaz de sentimientos, el ser humano se distingue de un mundo determinista y descubre su soledad y su marginación del resto del universo, que permanece indiferente ante sus esperanzas y sufrimientos. Esta, obviamente, fue la conclusión de los humanistas.

“Se haga caer la responsabilidad en un escepticismo global oculto por la cultura científica o en las conclusiones concretas de las diversas teorías científicas, la afirmación está a la orden del día: la ciencia desencanta al mundo, todo lo que ella describe se encuentra, sin remedio, reducido a un caso de aplicación de leyes generales desprovistas de interés particular” (Prigogine y Stengers, 1983 :34).

Se presenta, entonces, una disyuntiva, elegir la tentación de un mundo donde se encuentren los valores humanos, aunque se trate de un mundo irracional, o el elegir el mundo desencantado, extraño al hombre, pero racional y manipulable.

Esta disyuntiva fue inaugurada por Newton cuando, habiendo unificado el mundo sublunar y supralunar de Aristóteles en las mismas leyes, también lo dividió entre el mundo de cualidades y percepciones sensibles, donde amamos, vivimos y morimos, el mundo que la ciencia no puede explicar; y el mundo de la cantidad, en el que hay sitio para todo menos para el hombre, esto es, el mundo de la ciencia.

Se trata de la misma división establecida por Descartes, entre el mundo objetivo y el mundo subjetivo. Sin embargo, para numerosos científicos y filósofos de la ciencia esta concepción clásica, este paradigma dominado por el racionalismo a ultranza, la objetividad neutral, el determinismo, el afán verificacionista y el reduccionismo, ha terminado tambaleándose, ha llegado a su límite, y no merced a la crítica humanista sino debido a su propio desarrollo.

Los nuevos descubrimientos en campos como la física, la biología, la astrofísica, la neurociencia, entre otras, han demostrado que, en contraposición a un mundo lineal, mecánico y cuantitativo, nuestro universo es rico en diferencias cualitativas y sorpresas potenciales, un universo tan complejo y polifacético como lo es el hombre. La visión de la naturaleza ha experimentado un cambio hacia lo múltiple, lo evolutivo y lo complejo. “Dondequiera que miremos encontramos evolución, diversificación, inestabilidades. Curiosamente, esto es verdad en todos los niveles básicos, en el campo de las partículas elementales, en biología y en astrofísica, con la expansión del universo y la evolución de las estrellas que culmina en la formación de los agujeros negros” (Prigogine y Stengers, op.cit. :34).

Los fundamentos del nuevo paradigma epistémico nacen de las revelaciones hechas por la ciencia misma, es por ello que, para adentrarnos en los planteamientos de este paradigma, es necesario hacer un breve recorrido por las teorías y descubrimientos que han hecho tambalear los cimientos del paradigma clásico.

TEORÍAS.Y.DESCUBRIMIENTOS.

REVOLUCIONARIOS

A.-.La.Teoría.de.la.Relatividad

En líneas anteriores hemos ya mencionado la importancia de la aparición de esta teoría como elemento de ruptura con el paradigma clásico, en tanto pone en entredicho muchos de sus principios. •En esencia, la Teoría de la Relatividad introduce la idea de que lo observado depende del punto de referencia del sujeto, lo que cuestiona la objetividad pura del científico y otorga importancia al sujeto observador en el fenómeno observado: postula el conocimiento objetivo-subjetivo.

“Si en la física clásica, con el modelo mecanicista newtoniano-cartesiano, era posible, o al menos aceptable, separar al sujeto del objeto, en la física moderna, relativista, el observador y lo observado no pueden ya considerarse como separables, porque el observador llega a formar parte de la constitución del objeto observado” (Martínez, op.cit.: 79). Para esta teoría un observador del mundo es siempre un observador inmerso en él, no es alguien que contempla al mundo “desde afuera”, como lo veía la física newtoniana, para la que la descripción objetiva significaba ausencia de cualquier referencia a su autor.

“El hecho de que la relatividad se basa en una limitación que se aplica sólo a observadores físicamente localizados, a seres que pueden estar solamente en un lugar a un tiempo y no en ninguna parte, da a esta física una cualidad humana” (Prigogine, et.al. op.cit. :210).

Pero esto no significa que se trate de una física subjetiva, resultado de nuestras preferencias, sino que es una física sujeta a las limitaciones intrínsecas que nos identifican como parte del mundo físico que describimos. Ello contrapone a una física absoluta, una física humana, por ello se trata de un conocimiento subjetivo-objetivo.

•Por otra parte, la Teoría de la Relatividad introdujo la constante de la velocidad de la luz en el vacío (300,000 km/seg) como velocidad límite para la propagación de señales de cualquier tipo, sean electromagnéticas, sonoras, químicas... cuya universalidad radica en que puede ser aplicada sin tener en cuenta la escala de los objetos; sin embargo, el comportamiento de dichos objetos, dependiendo de su escala, varía según si su velocidad se acerca o no a la de la luz. Desde esta nueva visión, el universo homogéneo de Newton, no importaba si se trataba de átomos o estrellas, que se comportaba siempre igual por estar regido por leyes universales, deja de existir. Ahora, en el momento en que se introducen escalas físicas y constantes universales, los objetos tienen comportamientos cualitativamente distintos, de acuerdo a ellas.

Por otro lado, la introducción de la constante de la velocidad de la luz apoya la noción de subjetividad del observador, pues: “Ningún ser sometido a las leyes de la física puede transmitir señales a una velocidad mayor que la de la luz en el espacio (...) (por tanto) la simultaneidad absoluta de dos procesos distantes no puede ser definida” (Ibid.,210) excepto en términos de un determinado sistema de referencia.

•Con esta teoría se establece que el tiempo y el espacio no son entidades independientes y absolutas, sino que están unidas en una única unidad espacio-temporal. E igualmente hay una unidad indisoluble entre materia y energía, donde la primera es concentración de energía, una distorsión en la estructura del espacio. Esto contribuye a crear una visión del universo como una totalidad y no como una colección de elementos.

•También establece que el tiempo es parte constitutiva del ser de los átomos por lo que la materia es más una secuencia de acontecimientos que una colección de sustancias, por ello el tiempo es una cuarta dimensión. De ahí que, a diferencia de la física clásica donde el estado natural de la materia es el reposo, este nuevo concepto nos lleve a concluir que la realidad debe ser percibida como procesos o sucesos que se realizan en el tiempo.

B.La.Teoría.Cuántica

Esta Teoría, en particular el Principio de Indeterminación de Heisenberg, contribuyo a acabar con la causalidad lineal de la física newtoniana y con el determinismo, amén de contribuir, con la Teoría de la Relatividad, a socavar la supuesta objetividad de la ciencia.

•La teoría cuántica cuestiona la causalidad lineal, unidireccional de la física newtoniana y el determinismo, pues asegura que debido a la constante actividad de las partículas subatómicas que forman la materia, se producen al interior del átomo miríadas de colisiones entre las partículas subatómicas, imposibles de predecir por una relación causa-efecto. Es tan asombrosamente grande el número de colisiones entre partículas que no se puede decir lo que va a pasar en un determinado lugar, sólo puede expresarse como probabilidad de que ocurra. El conocimiento sobre las realidades subatómicas se vuelve entonces estadístico, pues las probabilidades de los eventos subatómicos están determinadas por la dinámica de todo el sistema. Esto acaba con el determinismo concebido por la física clásica.

•Por otra parte, de acuerdo a esta teoría, en el terreno de las realidades subatómicas la intervención del observador con sus instrumentos de medición perturba la realidad, de tal manera que se borra toda información sobre el estado anterior a la medición.

“El aspecto crucial de la teoría cuántica es que el observador no sólo es necesario para observar las propiedades de los fenómenos atómicos, sino también para provocar la aparición de estas propiedades. Por ejemplo, mi decisión consciente sobre la manera de observar un electrón determinará hasta cierto punto las propiedades (percibidas) de ese electrón. Si le hago una pregunta considerándolo como partícula, me responderá como partícula; si, en cambio, le hago una pregunta considerándolo una onda, me responderá como onda” (Martínez, 1997:82).

En la misma línea, Briggs y Peat afirman que con la teoría cuántica , “Los físicos (...) aprendieron que una unidad elemental de luz se puede comportar esquizofrenicamente como onda o como partícula, según lo que el experimentador escoja medir” (Briggs y Peat, op.cit. :28). Esto significa que el electrón no tiene propiedades objetivas que no dependan de mi mente. En el terreno de la física atómica es imposible mantener la distinción cartesiana entre mente y materia, lo que constituye una crítica más a la objetividad del paradigma.

•Además, afirma Heisenberg que la incertidumbre del científico al analizar el mundo de lo muy pequeño no es consecuencia de la imperfección de sus instrumentos o de las limitaciones de sus sentidos o de que su intervención perturbe la realidad, aunque todo ello hay que tenerlo en cuenta, sino, ante todo, se debe a que el observador, con su intervención, fuerza a una de las muchas posibilidades existentes a convertirse en realidad, como hace el escultor al extraer una estatua, de entre las muchas posibles, del bloque de mármol.

Afirma Heisenberg que “la transición de lo posible a lo real tiene lugar durante el acto de observación (...) y tiene lugar tan pronto como entra en juego la interacción del objeto con los instrumentos de medición, y por lo tanto con el resto del mundo” (Martínez, 1997:82).

Así, el pasado transmite al futuro una serie de probabilidades y sólo una de éstas llega a realizarse. El futuro no es algo desconocido sino algo que todavía no está decidido, pero tampoco es algo completamente abierto, pues el presente determina las futuras posibilidades y es el investigador el que fuerza una u otra posibilidad. Esto echa por tierra el determinismo y la causalidad del viejo paradigma. Por otra parte lleva a otra conclusión: “...si la acción humana sobre las realidades físicas es determinante y, a su vez, el hombre está influenciado por todo su entorno físico, biológico, psicológico, social y cultural, entonces, la teoría cuántica nos fuerza a ver el Universo no como una colección de objetos físicos, sino, más bien, como una complicada telaraña de relaciones entre las diversas partes de un todo unificado” (Martínez, op.cit. :83).

•Apoyando esta idea de totalidad, la Teoría“...también predice que dos “partículas”

cuánticas, separadas por varios metros de distancia y sin ningún mecanismo de comunicación intermedio, permanecerán no obstante misteriosamente correlacionadas” (Briggs y Peat, op.cit. :28).

Ello llevó a algunos científicos a concluir que el universo debe ser fundamentalmente indivisible, una totalidad fluida, en la que el observador no se puede separar totalmente de lo observado. En este sentido, las partes (como lo pueden ser las partículas o las ondas) son abstracciones a partir de esa totalidad fluida, pero son sólo relativamente autónomas, pues no tienen sentido sin el contexto de la totalidad.

“Son como el pasaje favorito de una sinfonía de Beethoven para el melómano. Si extraemos el pasaje de la pieza, es posible analizar las notas. Pero en última instancia el pasaje no tiene sentido sin la totalidad de la sinfonía” (Ibidem. :29). Como afirman los autores citados, estas concepciones buscan dar forma científica a la idea de que el universo es uno y acaban con la concepción de éste como un continum. El Universo, de acuerdo a la nueva física, resulta así indeterminado, esencialmente dinámico, interrelacionado como un sistema de interacciones entre sus partes y unificado como una totalidad.

C..La.Segunda.Ley.de.la.Termodinámica.

Uno de los aspectos fundamentales de la ciencia newtoniana-cartesiana es su concepto del tiempo en relación a un mundo estático y permanente. En un universo así, el tiempo es absoluto e independiente del espacio, es sólo una medida del movimiento, un parámetro en el que presente y futuro son equivalentes porque las leyes que gobiernan el universo son inmutables y eternas y lo mismo rigen el pasado que el presente o el futuro. Por ello el factor tiempo no importa, es una ilusión, un invento del hombre.

Las leyes del universo salvan la temporalidad y por ello el tiempo es reversible y el determinismo es posible. Por otro lado, ya analizamos también como concepto central de este paradigma la concepción de un universo ordenado y simple, detrás del aparente caos y desorden que se percibe en la complejidad de la realidad. La tarea de la ciencia es entonces develar el orden detrás del caos, hacer simple lo complejo, y para ello la mejor fórmula es el reduccionismo, el fragmentar la realidad para hacerla clara y comprensible. A principios del siglo XIX aparece el primer golpe a la construcción newtoniana, específicamente a este concepto del tiempo y al del orden y simplicidad en el universo, a través de la ciencia de la termodinámica inaugurada por Fourier con su Ley de la propagación del calor como un proceso irreversible y, concretamente, con el segundo principio o Segunda Ley de la Termodinámica, esencialmente dinámico, que, a decir de Prigogine, introduce la idea de la flecha del tiempo. Ya desde el siglo XVIII los científicos se preguntaban por qué no podían crear una máquina de movimiento perpetuo, y descubrieron que el problema radicaba en que cada vez que la ponían en funcionamiento parte de la energía que le inyectaban cobraba la forma de calor y resultaba irrecuperable. Este descubrimiento, que inauguró la ciencia del calor, demostró que la propagación de éste es un proceso irreversible y que esta transformación de la energía la convertía en algo desorganizado y caótico.

Este primer principio de la termodinámica llevó a otro que causó un desconcierto mayor: el principio de la entropía.

La Segunda Ley de la Termodinámica en su interpretación más general establece que a cada instante el universo se hace más desordenado. Este desorden se traduce en un deterioro general e inexorable hacia el caos. Uno de los patrones más generales de comportamiento del mundo físico es la tendencia de las cosas a desgastarse y agotarse, esto es, las cosas tienden a un estado de equilibrio termodinámico, a una pérdida de energía en forma de calor. Para cuantificar este desorden, los científicos inventaron una magnitud matemática: la entropía. En términos más específicos esta ley afirma que con la expansión del universo la calidad de la energía disponible en él se degrada, aunque la cantidad continúe siendo la misma. Cuando la energía se encuentra localizada, concentrada, tiene potencialidad para producir cambios, es útil, pero cuando se ha dispersado en forma caótica, su calidad baja y pierde su potencialidad de generar movimiento y cambio. “La degradación de la calidad es dispersión caótica” (Instituto de Investigación para una Coevolución Creativa, 1997:1). De acuerdo a la segunda ley de la termodinámica esta tendencia a la degradación o dispersión caótica sucede en sistemas cerrados que no reciben energía del exterior (de ahí la imposibilidad de que existan máquinas de movimiento perpetuo que no requieran renovar su energía).

La forma final de la energía degradada es el calor y sin energía exterior todo sistema cerrado termina por deteriorarse hasta alcanzar una inercia total. Ahora bien, considerando que la cantidad total de energía de nuestro universo se mantiene constante y que éste es un sistema cerrado, la conclusión a la que llegaron los físicos es que, de acuerdo a la 2da Ley de la Termodinámica, después de cierto tiempo la energía total del universo terminará degradándose y transformándose en calor, por lo que el cosmos habrá llegado a su fin en lo que los científicos han llamado: la muerte térmica del Universo.

“Se ha descubierto en el universo físico un principio hemorrágico de degradación y de desorden...” (Morin, op.cit. :33). Mientras que los científicos del siglo XIX ignoraron las implicaciones de este descubrimiento, limitándose, como lo hizo Ludwig Boltzmann a afirmar que este principio no aplicaba en el nivel reduccionista de los átomos y las moléculas, para los promotores del nuevo paradigma, como Ilya Prigogine, la 2ª Ley de la Termodinámica tiene dos implicaciones:

•Demostraba que en el universo existen dos tipos de procesos: los reversibles, que no dependen de la dirección del tiempo y los irreversibles que dependen de ella. Estos últimos son procesos que tienen historia, que evolucionan, que tienen un principio y un fin, y en los cuales las leyes inmutables y eternas, los procesos mecánicos y repetibles, no tienen aplicación.

•Introduce la idea del caos, del desorden, en un universo que, mediante las Leyes y esquemas racionales iniciados por Newton, estaba en camino de revelar su eterna armonía, su orden inmutable detrás de la complejidad y el caos aparente. “¿Acaso el hecho de que una máquina necesitara constantemente nueva energía y de que todas las formas estén condenadas a ser aplastadas bajo el talón de una entropía y un deterioro acumulativos significaba que el caos es un principio tan poderoso como el del orden?” (Briggs y Peat, op.cit.:22). Estos descubrimientos en el terreno de la Termodinámica demostraban que el inmutable Universo de Newton regido por leyes eternas que se han repetido, se repiten y se repetirán hasta la eternidad, está en realidad amenazado por el caos y por la emergencia de lo nuevo, lo desconocido y lo imprevisible.

D..El.Evolucionismo

El descubrimiento de otros procesos evolutivos en la naturaleza constituyó otro duro golpe contra la concepción mecanicista y reduccionista de la ciencia clásica.

El siglo XIX fue el siglo de la evolución en biología, geología y sociología, que puso el acento en los procesos de cambio y de incremento de la complejidad. El descubrimiento realizado por Charles Darwin y Alfred Russel Wallace sobre la aparición de nuevas formas de vida por medio de un proceso evolutivo donde el azar y la probabilidad resultan factores clave, rompen con la concepción mecanicista clásica Y la idea de que éstos no conducen a una alteración o destrucción del orden del mundo (como era el caso de la entropía en termodinámica), que no responden a un comportamiento constante del universo y que no conllevan a la conformación de estructuras simples, sino a la constitución de formas novedosas y más complejas, implica hacer tambalear los cimientos del paradigma dominante, pues nuevamente demuestra que en el Universo los procesos no se repiten sin variación alguna en un movimiento sin fin, sino que la naturaleza es capaz de generar formas novedosas que se caracterizan por su creciente complejidad. Además: “...Darwin y Wallace entendían que el azar la probabilidad- era un factor clave en los procesos mecanicistas que gobernaban las formas complejas. Pero aquí, en vez de alterar el orden complejo y destruirlo, el azar causaba variaciones en los individuos de las especies existentes. Algunas de estas variaciones sobrevivían y conducían a especies nuevas” (Briggs y Peat, op.cit. :22).

Por otro lado, el mecanismo de la evolución requiere de sistemas distintos a los sistemas cerrados a que hace referencia la Segunda Ley de la Termodinámica, hacen falta sistemas capaces de intercambiar energía con el entorno, sistemas que eluden la entropía del universo y, en cambio, generan orden a partir del caos, un orden que se caracteriza por su progresiva complejidad. Darwin estableció también que nuestra especie posee una solidaridad con el resto de las formas vivas, en tanto responde al mismo proceso evolutivo. Por otra parte, el evolucionismo refuerza la idea establecida por Prigogine de la existencia de una flecha del tiempo que permite hablar de irreversibilidad de los procesos, por tanto, de indeterminismo en tanto no es posible predecir cuáles serán los derroteros que tomará la evolución a futuro, qué nuevas especies aparecerán o qué ocurrirá con las que ahora existen. El tiempo en el evolucionismo sólo tiene una vía, no podemos hablar de productos o fenómenos que se repitan en la misma forma ni podemos esperar que alguno se reproduzca en lo futuro. La evolución es un proceso único, sin patrones repetidos, que manifiesta la emergencia continua de fenómenos nuevos, imposibles de predecir. El concepto evolucionista y, por tanto, la idea de un tiempo irreversible, pasó de la biología a disciplinas como la geología, las ciencias de la sociedad y también, como ya lo vimos, al nivel cósmico. Aunado al concepto de entropía, con los descubrimientos de Edwin Hubbel sobre el alejamiento de las galaxias, la consecuente teoría de la expansión del Universo y la teoría del Big Bang, se empezó a hablar de una historia del cosmos, de un principio y un probable fin, que pusieron nuevamente en entredicho las inmutables leyes de la ciencia newtoniana.

En concreto, el evolucionismo introdujo la idea de un Universo:

•No estático, sino evolutivo e irreversible.

•No mecánico, sino sujeto al azar.

•Donde los procesos de cambio llevan a algo novedoso y cada vez más complejo.

E..La.Teoría.de.las.Estructuras.Disipativas.

Esta teoría es obra de Ilya Prigogine, Premio Nobel de química en 1977, y se desprende de las teorías anteriores. En función de la Ley de la Entropía que postula que el Universo tiende a la muerte térmica como perspectiva final, esto es, al caos, al desorden, puede concluirse que las manifestaciones de orden y organización, tales como la vida, son un hecho fortuito, fruto del azar, algo raro e inútil. Pero en opinión de Prigogine esto no es así, pues de acuerdo a su teoría sobre las estructuras disipativas la vida, a diferencia del universo, va “hacia arriba”, en lugar de ir “cuesta abajo”.

“La tendencia hacia el caos, hacia la desorganización molecular descrita por la segunda ley de la termodinámica, es incompatible con la evidencia de que los sistemas biológicos tienden, por lo menos temporalmente, a hacerse más complejos y eficientes. Ilya Prigogine contribuyó a la solución de este problema mediante modelos matemáticos en que introduce el concepto de la termodinámica para los sistemas abiertos y disipativos en no equilibrio con el medio ambiente y que, sin embargo, mantienen una estructura interna estable...” (Estañol y Césarman, 1994: 60). Para ello, este autor parte de oponer a los sistemas cerrados que tienden a un estado de equilibrio energético, los sistemas abiertos que mantienen un constante flujo de energía con el medio ambiente.

Para este autor estos sistemas son estructuras disipativas que se mantienen por una continua disipación o consumo de energía, y cuanto más compleja sea esta estructura más energía necesita para mantener sus conexiones, lo que la hace más vulnerable a fluctuaciones internas y más lejana a mantener un estado de equilibrio. Las estructuras disipativas se comportan más como organismos biológicos que responden a los cambios del medio que como materia inerte regida por leyes mecánicas, en un estado de equilibrio. “...puede decirse que las estructuras se adaptan a las condiciones exteriores, constituyendo un tipo de mecanismo de adaptación prebiológico” (Prigogine y Stengers, op.cit.:23).

Para Prigogine los seres vivos son sistemas abiertos desde el punto de vista termodinámico, esto es, sistemas que intercambian materia y energía con el medio ambiente. “La energía que entra a los seres vivos es utlizada para crear orden y (...) para crear una fuerza dentro de los organismos que se opone a la entropía y que se ha llamado entropía negativa o neguentropía y que representa estructura, complejidad, organización e información” (Estañol y Césarman, op.cit. :91).

Desde este punto de vista la vida se nos aparece como más en contra de las leyes de la física para evitar su destino natural: la destrucción total, la entropía. Para el autor el desequilibrio y la complejidad son clave en estas estructuras para oponerse al caos entrópico, pues mientras la estructura esté más intrincadamente conectada, es decir, mientras sea más compleja, (más coherente, según Prigogine), más inestable resulta por sus requerimientos de energía y por tanto por su dependencia del entorno; pero esta inestabilidad es la clave de la transformación del sistema hacia nuevas estructuras más organizadas y complejas, pues la disipación de la energía crea el potencial para un repentino reordenamiento, para un cambio que implica mayor orden. Por ello: “Ilya Prigogine ha llamado a los seres vivos estructuras disipativas en no-equilibrio” (Ibidem. :91).

Este concepto implica que los seres vivos absorben energía libre y materia del entorno y con ello producen orden, un estado estacionario y neguentropía dentro de sí mismos, pero, a cambio, disipan parte de esta energía en forma de calor al medio ambiente, por ello son estructuras disipativas. Y les llama en “no equilibrio” por ir en contra de este equilibrio termodinámico que predice la segunda ley de la termodinámica. En concreto, el continuo movimiento de energía a través de estos sistemas vivos genera fluctuaciones y si estas aumentan a un grado crítico perturban el sistema, aumentando el número de sus interacciones y creando nuevas conexiones que dan lugar a una reorganización de las partes del viejo sistema, entonces éste adquiere un orden superior, más complejo, con mayores conexiones que el anterior y que, por lo mismo, requiere de mayor intercambio de energía, originando nuevamente fluctuaciones, inestabilidad y nuevas transformaciones.

Prigogine introduce de nuevo la idea de evolución en un mundo pasivo, la emergencia de la novedad en un universo mecánico y determinista, la línea del tiempo en una concepción de inmutabilidad y reversibilidad, la complejidad que ha tratado de eludir el paradigma simplificador de Newton y algo nuevo: la idea de que del desorden puede surgir orden y que la materia es capaz de procesos de auto-organización.

“Lejos del equilibrio, en las situaciones de inestabilidad, los procesos irreversibles

(...) no siguen la ley de la entropía y la evolución hacia el desorden sino parcialmente: al contrario, son fuente de coherencia, ya que pueden exportar esta entropía a su entorno e incrementar, en vez de disminuir, su orden interno. La aparición de esta actividad coherente de la materia (...) nos impone un cambio de perspectiva, de enfoque, en el sentido de que debemos reconocer que nos permite

hablar de estructuras en desequilibrio como fenómenos de “autoorganización” (Martínez, op.cit. :130).

F..La.Teoría.de.Sistemas

Esta teoría se refiere a una forma novedosa de enfocar a la naturaleza. Parte de la idea de sistema desarrollada en Física, en particular en Termodinámica como ya lo vimos en líneas anteriores, y aplicable a la ingeniería energética (liberación de grandes cantidades de energía en maquinas de vapor o eléctricas) y a la ingeniería de control, base de las computadoras y la automatización, que hace surgir máquinas que se autocontrolan, desde el termostato casero hasta los modernos proyectiles autoregulados. Este enfoque de sistemas se transformó en una Teoría General de Sistemas (TGS), con la confluencia de dos vertientes: la biológica, encabezada por Ludwig Von Bertalanffy, y la cibernética, con Norbert Wiener.

La vertiente biológica de Bertalanffy aportó a la TGS conceptos como orden, organización, totalidad y teleología. Mientras que la vertiente cibernética de Wiener complementó a la Teoría con términos como retroalimentación, regulación y control.

•La. vertiente. biológica. de. Ludwig. Von. Bertalanffy.

La Teoría General de Sistemas es originalmente obra de este autor, originada en 1937, quien sentó sus bases partiendo de sus preocupaciones en el terreno biológico. Bertalanffy fue influenciado por la visión denominada organísmica en Biología, que enfocaba a los organismos como sistemas, siendo tarea de la ciencia descubrir sus principios de organización. Esta visión organísmica se oponía a la visión mecanicista positiva que veía a los seres vivos como máquinas. Bertalanffy trató de dar forma al programa organísmico en asuntos sobre metabolismo, crecimiento y biofísica del organismo, empleando para ello la teoría de los sistemas abiertos inaugurada por la Física. Pero Bertalanffy no se limitó al terreno biológico pues: “Me dio la impresión de que no podía detenerme en el camino que había elegido, y ello me condujo a una generalización mayor aún, a la que llamé teoría general de los sistemas” (Bertalanffy, 1984:93). La Teoría General de Sistemas pretende descubrir las realidades susceptibles de ser interpretadas como sistemas. Trata de buscar los principios generales que sean aplicables a diferentes ámbitos científicos como una visión sintética de la realidad en un afán interdisciplinario, creando estructuras interpretativas de validez generalizada basadas en las redes de relaciones de los sistemas. Bertalanffy afirma que el asunto de la TGS es la formulación y derivación de los principios válidos para todos los sistemas en general. La idea es buscar principios aplicables a los sistemas sin importar de qué tipo sean: biológicos, sociales, psicológicos, físicos... Yafirma que al haber propiedades generales a todos los sistemas existen similaridades estructurales (isomorfismos) en los diferentes campos del saber, esto es, principios que rigen el comportamiento de entidades intrínsecamente diferentes.

“La TGS es un campo lógico-matemático cuya tarea es formular y derivar aquellos principios fundamentales que sean aplicables a “sistemas” en general. De esta manera se vuelven posibles formulaciones exactas en términos tales como totalidad y suma, diferenciación, mecanización progresiva, centralización, orden jerárquico, finalidad y equifinalidad, etc. Términos que se presentan en todas las ciencias que se ocupan de “sistemas”, e implican su homología lógica” (Bertalanffy, op.cit.).

Para la TGS existen dos clases de sistemas:

•Los sistemas cerrados, donde la interacción entre el sistema y el medio es mínima (sistemas mecánicos). Su estado es de equilibrio.

•Los sistemas abiertos, cuando existe una interacción entre el sistema y el medio circundante, lo que obliga al primero a mantener una adaptación constante (por ejemplo, los seres vivos). Su estado no es de equilibrio. En los sistemas abiertos el medio aparece como un suprasistema influyente que engloba al sistema. Estos sistemas abiertos tienen un carácter de totalidad, dinamismo, teleología, retroalimentación e información.

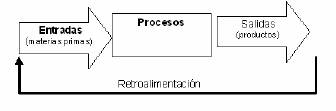

Un diagrama general aplicable a este tipo de sistemas en cualquier ámbito, se ilustraría así:

Sistema

Algunos de los principios que rigen la TGS son:

a) Principio de equifinalidad. En los sistemas cerrados el estado final del sistema está determinado por las condiciones iniciales, por ejemplo, en los compuestos químicos las concentraciones finales de éstos dependen de las concentraciones iniciales. En estos sistemas existe el principio de equifinalida, que consiste en que los sistemas pueden alcanzar el mismo estado final partiendo de diferentes condiciones iniciales y por diferentes caminos, por ejemplo la formación de un ser vivo a partir de un cigoto o de la división de uno en dos.

b) Principio de Neguentropía. La tendencia general en los sistemas cerrados es hacia el máximo desorden: entropía, hacia la igualación de las diferencias y la muerte térmica. En cambio, en los sistemas abiertos existe la neguentropía o tendencia al orden, que se da al importar información (elementos, material, energía...) del medio ambiente, lo que lo mantiene en un estado uniforme o lo lleva a estados de orden y organización crecientes.

c) Principio de causalidad y teleología. En la ciencia positivista el mundo es susceptible de descomponerse en unidades fundamentales (átomos) regidos por leyes inexorables de causalidad y donde no hay lugar para una finalidad (telos) vista como un concepto metafísico, por lo que la ciencia resulta analítica, esto es, divide la realidad en unidades y aisla las causas separadas de cada fenómeno. En consecuencia las leyes que rigen al mundo no tienen un propósito. En cambio, con la TGS surge la idea de un todo compuesto de partes en interacción y que cuentan con una tendencia a la adaptación, la intencionalidad y la persecución de metas.

La TGS busca idear modelos, matemáticos o no, que expliquen este comportamiento.

d) Organización. Es también éste un concepto novedoso no empleado por la ciencia mecanicista. Los sistemas son elementos organizados que interactúan hacia una meta y la organización implica nociones de totalidad, crecimiento, diferenciación, control, orden jerárquico, competencia...

e) Visión de la realidad como compleja y sistémica. La TGS promulga una realidad sistémica, es decir, una realidad en cuanto sistema, puesto que se trata de un todo conformado por la relación entre sus elementos.

Pero además de ser relacional, la realidad es sincrética, global, conglomerada y total y por tanto compleja, por lo que su estudio sólo podrá realizarse a través de un método que se adecue a la esencia de la realidad, que lejos de separar y atomizar el mundo real en diversas realidades diferenciadas y por tanto distintas disciplinas para estudiar cada realidad, asuma lo que las une. En ese sentido: “La TGS aparece como una forma de asumir la complejidad de la realidad.” (Ander-Egg, 1994:48) e intenta alzarse como metodología de la interdisciplinariedad al mismo tiempo que como metodología apta y común para cualquier ciencia.

f) Unidad de la ciencia. Como vemos, la TGS tiene implicaciones interdisciplinarias. Esta teoría tiende hacia la unidad de la ciencia en tanto implica una concepción unitaria del mundo y no es una reducción de todos los niveles de la realidad a la Física, sino que los diferentes campos de la realidad siguen las mismas leyes pues su comportamiento es similar en tanto se trata de sistemas. Esto es, existen leyes iguales para diferentes campos de la realidad en tanto que estos campos son sistemas (se trata entonces de leyes que rigen sistemas), ya que la realidad vista en términos de sistemas tiene el mismo comportamiento, no importando sus particularidades. Es por ello que se trata de una concepción no reduccionista (en la que los diferentes aspectos de la realidad se subordinan a las leyes de la física). Como consecuencia de la unificación de la ciencia se plantea, en el terreno de la educación, llegar a una institución integrada que forme generalistas científicos, individuos no especializados con un enfoque más sencillo y unificado de los problemas científicos, practicantes de LA CIENCIA, que formarían parte de los equipos de investigación para encargarse de los problemas de sistemas. En esta nueva educación se enseñarían principios básicos interdisciplinarios que equivaldrían en esencia a los principios de la TGS.

•La. . vertiente. cibernética. de. Norbert. Wiener

Otro principio esencial que rige a la TGS es el principio de información y retroalimentación, pero por ser ambos elementos el aporte de la vertiente cibernética de Wiener los trataremos en este apartado. Para Bertalanffy la Cibernética es sólo parte de una teoría de sistemas basada en los conceptos de información y retroalimentación, pero se trata en realidad de una corriente complementaria que ha brindado estos dos grandes aportes a la TGS. Colom Cañelas (1982) define Cibernética como el estudio de los sistemas de autogestión, del control y de los procesos comunicativos-informativos del propio sistema, así como de sus consecuencias, como base para formular una ciencia de la relación (verdadero objeto de la cibernética).

Para Norbert Wiener la Cibernética es la ciencia del control y de la comunicación y se preocupa por las relaciones existentes entre los sistemas abiertos y el medio, pues a partir de esta comunicación el sistema debe ejercer funciones de autorregulación y perfeccionamiento para llegar a la optimización, entendida como el proceso por el cual se tiende a reducir la distancia entre la situación real del sistema y la situación ideal marcada por sus metas, en lo cual tiene un papel preponderante el medio.

Como ciencia del control, la cibernética se ocupa del proceso de autorregulación del sistema como forma de adaptación y como forma de alcanzar sus metas, ello supone un control interno del funcionamiento del sistema y un control externo de la información que ingresa de fuera del mismo. Estos controles se ejercen a través de un mecanismo de retroalimentación o realimentación, que puede ser de dos tipos:

•Una inmediata (feed back), que se realiza para mantener el equilibrio interno (por ejemplo los termostatos) Se trata de una adaptación reactiva y domina en sistemas cerrados.

•Una mediata (feed before) que se realiza con una función finalística para alcanzar las metas del sistema, y es ésta la que permite la evolución de los sistemas, se trata de una realimentación proyectiva, por ejemplo la de un organismo vivo. Este tipo de adaptación, al ser proyectiva y no reactiva, supera el mecanismo estímulo- respuesta y supone la intervención dinámica del sistema con el medio. Este tipo de control es dominante en sistemas abiertos. Como ciencia de la comunicación la cibernética incluye como elemento esencial a la información. La relación de los sistemas con el medio toma la forma de una comunicación donde se intercambia información y al interior del sistema esta información es transformada. Para la cibernética la información tiene propiedades de neguentropía, pues tiende a disminuir el desorden y producir orden en el sistema.

Como vemos, la TGS representa una reacción contra el paradigma clásico y la búsqueda de una nueva visión de la realidad como sistema y del conocimiento como un producto unificado que a partir de ella se genera. Como conclusión diremos simplemente que la TGS es considerada por Bertalanffy la ciencia de la totalidad, y sus finalidades serían:

•La tendencia general a la integración de las ciencias naturales y sociales.

•La búsqueda de una teoría exacta en ciencia no físicas.

•La elaboración de principios unificadores que recorran verticalmente todo el universo de las ciencias.

•La implementación de una enseñanza integral de la ciencia.

G).La.Teoría.de.la.Complejidad

Ésta se refiere a una forma de descripción de la naturaleza y sostiene que distintas situaciones de observación, que al principio pueden parecer contradictorias y excluyentes, resultan complementarias entre sí. Niels Bohr introdujo este concepto para explicar la relación entre pares de conceptos clásicos. Éste, por ejemplo, es el caso de las observaciones del comportamiento de la luz como onda y como partícula, que resultan dos observaciones complementarias de una misma realidad, por tanto sólo parcialmente correctas si se las toma por separado. Para Bohr ambas imágenes son necesarias para dar una visión completa de la realidad atómica. El principio de complementariedad puede concretarse en los siguientes puntos:

a)Un determinado fenómeno se manifiesta al observador en modos conflictivos.

b)La descripción de este fenómeno depende del modo de observarlo.

c)Cada descripción es racional, es decir, tiene una lógica consistente.

d)Ningún modelo puede subsumirse o incluirse en otro.

e)En vista de que pueden referirse a la misma realidad, las descripciones complementarias no son independientes unas de otras.

f)Los modos alternos de descripción llevan a predicciones incompatibles.

g)Ninguno de los modelos complementarios de un determinado fenómeno es completo (Martínez, 1997:154).

“La noción de complementariedad se ha convertido en parte esencial del concepto de la naturaleza sostenido por los físicos, y Bohr sugirió repetidas veces que tal vez esta noción podría resultar útil fuera del campo de la física” (Martínez, op.cit.:88). Y así es en efecto, pues muchos han recurrido a tal noción para explicar como complementarios los análisis mecanicistas y orgánicos, las descripciones conductuales e introspeccionistas, la mente y el cerebro, la teleología y el mecanicismo, el libre albedrío y el determinismo...

De igual manera la ciencia, la filosofía, la historia y el arte pueden considerarse modos diferentes y complementarios de describir una misma realidad.

Fuentes.consultadas

•Ander-Egg, Ezequiel (1994) Interdisciplinariedad en Educación. Edit. Magisterio del Río de la Plata. Buenos Aires. 93 pp.

Logo del II Congreso Mundial de Transdisciplinarie

|

![]()